前面的文章里,我们给 RKYOLO 搭好了结实的地基——安全的 FFI 层和聪明的后处理。项目是能跑了,但作为一个爱折腾的人,我总觉得还能再抠点性能出来。

当我琢磨怎么用它来处理实时视频流时,我意识到真正的挑战来了。目标不再是“能跑”,而是得“跑得飞起”。为此,我决定去碰一碰性能优化里最硬的那块骨头——**零拷贝(Zero-Copy)**。

为啥先跟“零拷贝”过不去?

你可能会想,为啥不先做视频播放这些看得见的功能呢?

我的想法很简单:得先把基础打牢。零拷贝是底层性能的根基。处理一张图时,省下那几毫秒可能感觉不出来,但要是每秒处理 30 帧、60 帧视频,这点时间省下来就是天壤之别。我得先让“引擎”马力十足,再去考虑“车身”漂不漂亮。

性能暗坑:那个偷偷干活的memcpy

首先得找到问题在哪儿。在标准的推理流程里,rknn_inputs_set 这个函数看起来没啥,但它背后偷偷执行了一次内存拷贝(memcpy)。CPU 得把预处理好的图像数据,从用户态内存复制一份到 NPU 能直接访问的物理内存(DMA 缓冲区)里。

这就像有个手脚麻利的厨师(NPU),但每次做菜前,都得等一个慢悠悠的服务员(CPU)把食材从仓库(CPU 内存)搬到灶台(NPU 内存)上。厨师大部分时间都在干等,整体效率自然高不了。

零拷贝就是想绕开这个服务员,让食材直接出现在厨师的灶台上,彻底省掉“搬运”这步。

三步搞定零拷贝:和硬件直接打交道

要实现零拷贝,就不能再用现成的高级 API 了。我啃了瑞芯微的官方开发文档,总算摸清了门路。

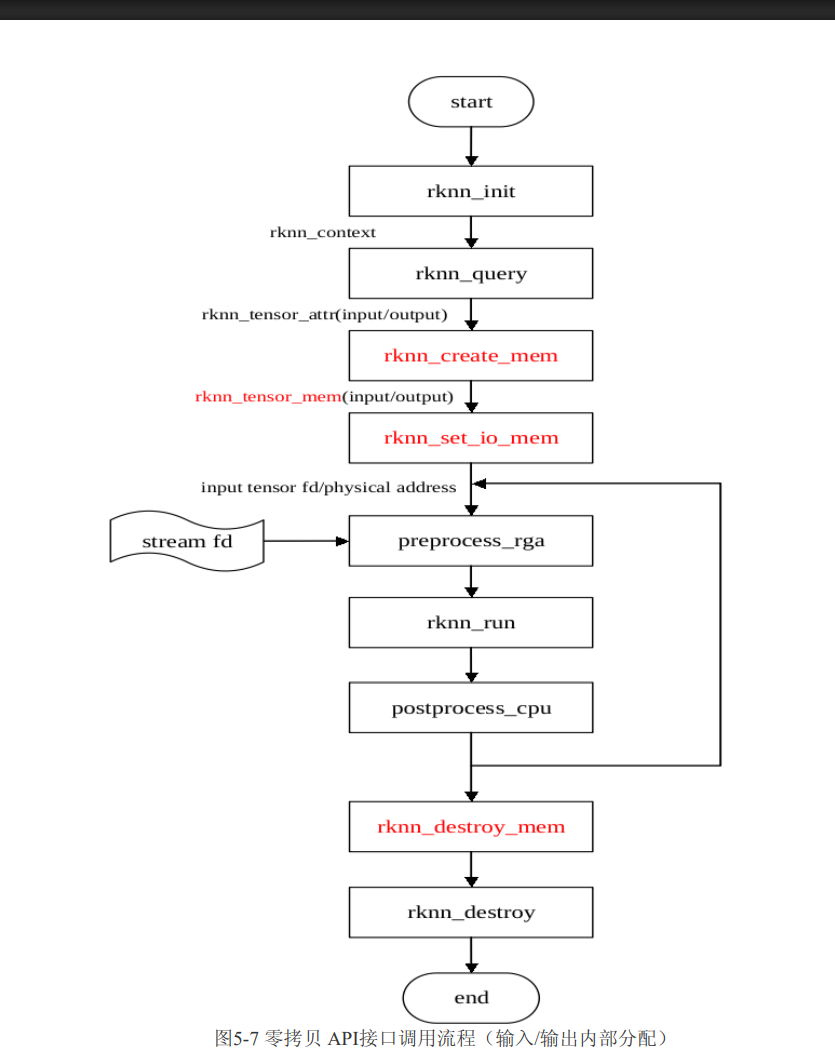

(图:官方零拷贝 API 调用流程图)

图注:瑞芯微官方文档里的零拷贝流程图,指明了rknn_create_mem和rknn_set_io_mem是关键。

照着这份“地图”,我开始了零拷贝的“三步走”:

1. 先问问 NPU 喜欢啥样的“盘子” (query_native_input_attrs)

文档里特别强调了要查“原生”属性:

1 | rknn_query() |

这个 NATIVE 版本的查询特别关键,它能告诉我 NPU 硬件原生的内存布局要求,这些要求往往很具体:

(图:官方零拷贝输入对齐要求)

图注:官方文档说,在 RK3588 上,4 维输入的通道需要做 16 字节对齐。

这个对齐要求,最终体现在 rknn_tensor_attr 结构体的一个参数上——w_stride(行步长)。这是搞定零拷贝的第一把钥匙。

2. 在厨房申请个“专用灶台” (rknn_create_mem)

下一步是 rknn_create_mem。这个函数会在 DMA(直接内存访问)区域申请一块“专用灶台”。这块内存很神奇,CPU 和 NPU 都能直接访问。

3. 告诉 NPU 以后就用这个“灶台” (rknn_set_io_mem)

最后,通过 rknn_set_io_mem,我告诉 NPU:“以后你的输入,就直接从我刚申请的那块 DMA 内存里读,别的地方不用看了。”

踩坑实录:零拷贝从来不会乖乖工作

当我按这个流程实现完,一运行——得,模型输出又花屏了!得,又掉进和硬件打交道的坑里了。

第一个坑:步长单位的迷惑

我马上打开详细日志,在预处理函数里加打印。很快就发现了关键线索:

1 | [DEBUG rkyolo_core] Quantization and stride-aware copy complete. Line bytes=1920, Stride bytes=640 |

出问题了! 一行图像数据实际有 640*3=1920 字节,但日志显示步长只有 640。我立刻反应过来:我搞错了 w_stride 的单位!我以为是字节,其实它代表的是像素!

我回去翻文档,看到这么一句:

1 | b. 当layout为 RKNN_TENSOR_NHWC 时,... 需要注意的是当 pass_through=1 时,width可能需要做stride对齐,具体取决于查询出来的 w_stride的值。 |

果然如此。NPU 为了对齐内存,硬件层面处理的“行”宽度(w_stride,单位像素)可能比图像实际宽度大。我之前的理解错了,导致内存写飞了。

赶紧修正步长计算:let stride_bytes = w_stride as usize * 3;。就这小小的 * 3,是我踩坑换来的教训。

第二个坑:隐藏的数据类型陷阱

修好步长,结果还是不对。我想起上次“指鹿为马”的教训,马上怀疑是数据类型问题。在零拷贝模式下,我需要把 i8 类型的量化值直接写入 &mut [u8] 类型的 DMA 缓冲区。我一开始这么写:

1 | // 错误写法 |

这是个很隐蔽的坑。as u8 做的是数值转换,会彻底破坏负数的二进制表示。正确做法是按位转换,保留原始的二进制位。

1 | // 正确做法 |

修好这个隐藏的 Bug 后,零拷贝模式下的推理结果,总算和标准模式一样了!

留个后路:追求速度,但不能不顾稳定

零拷贝是搞定了,但我又想了想:万一程序跑在旧驱动上,不支持零拷贝咋办?直接崩了可不行。

所以,我做了个“优雅降级”机制。

1 | pub enum ExecutionMode { |

我搞了个 ExecutionMode 枚举来代表两种运行模式。程序启动时,会调用 try_setup_zero_copy 函数尝试初始化零拷贝。这里每一步都包在 Result 里,任何一步失败了,它不会崩,而是打条警告日志,然后退回 Standard 模式。主逻辑里用一个 match 语句无缝处理两种模式。

这是个设计原则:稳字当头。 程序得先能跑,再追求跑得快。

最终成果:每毫秒都来之不易

折腾这么久,零拷贝到底提升多少?我用 time 命令给单张图片处理做了性能测试。

标准模式(要拷贝内存)

1 | > time target/release/rkyolo-app ... |

零拷贝模式

1 | > time target/release/rkyolo-app ... |

战果汇报:

- 省了多少时间:

0.550s - 0.507s =43 毫秒 - 性能提升:

(43ms / 550ms) * 100% ≈7.8%

单张图片上,我们拿到了近 8%的性能提升。这点提升在实时视频流里会被放大,直接决定应用流不流畅。这 43 毫秒的胜利,是我跟硬件死磕、细读文档、狠抓细节、不忘稳健的结果。

看到单张图片节省 43 毫秒的结果,可能有人会觉得投入产出比不高。确实,如果只处理几张图片,这个优化的意义不大。但我之所以坚持先攻克它,源于我对构建高性能系统的一种理解:优化必须自底向上,先夯实基础,再搭建上层建筑。

为什么必须先做零拷贝,再做视频流?

这背后是一种简单的工程哲学:如果我连单张图片的数据传输都无法优化到极致,又怎么可能处理好连续不断的视频流呢?视频流本质上是海量图片的连续处理,任何微小的效率损耗都会被无限放大。如果底层基础不稳,上层应用越是复杂,整个系统就会越摇摇欲坠。

我希望先打造一个尽可能高效的“引擎”,确保核心推理路径是最优的,然后再去为它添加“轮子”和“外壳”(比如视频流处理、结果显示等功能)。这个顺序不能颠倒。

零拷贝的“可怕”之处在于规模的放大效应

虽然单次节省 43 毫秒看似不起眼,但当我们将其置于真实的、高负载的应用场景中时,它的价值就会以惊人的方式展现出来:

场景一:多路视频流处理

假设我们需要同时处理 4 路 1080p@30fps 的视频流。

标准模式下的额外开销:每秒会产生 4 路 _ 30 帧 _ 43 毫秒 ≈ 5.16 秒 的 CPU 计算量。这意味着,仅内存拷贝就会占用超过 5 个 CPU 核心的算力,极易造成系统卡顿和丢帧。

零拷贝模式下的开销:这部分开销几乎降为零。释放出的巨大 CPU 资源可以用于处理更多路视频或更复杂的算法,从根本上提升了系统的吞吐能力和稳定性。

场景二:应对 4K@60fps 的极限挑战

4K 分辨率的数据量大约是 1080p 的 4 倍。我们保守估计,其单帧拷贝耗时约为 1080p 的 2.5 倍,即 107.5 毫秒。

标准模式下的瓶颈:处理一路 4K@60fps 视频,仅拷贝数据每年秒就需要 60 帧 * 107.5 毫秒 = 6.45 秒 的 CPU 时间。这个数字是毁灭性的,它直接宣告了在嵌入式设备上实现实时处理是不可能的。

零拷贝带来的可能性:正是通过消除这个巨大的瓶颈,我们才为后续所有的优化(模型量化、算子融合等)争取了宝贵的资源,使得挑战这种极限场景成为了可能。

结论

因此,这 43 毫秒的优化,远不止是一个数字游戏。它是我对系统底层性能的一种执着,是对“兵马未动,粮草先行”这一理念的实践。它意味着系统架构拥有了一个高效、可靠的地基。在这个地基上,我们才能放心地去构建各种强大而复杂的上层应用(如多路视频流分析),并确保它们能够稳健、高效地运行。这种对底层细节的关注和投入,正是追求极致性能的必经之路。